Entropía

La entropía, de símbolo S, es una magnitud física que describe la tendencia natural de los sistemas a evolucionar hacia estados de mayor desorden o aleatoriedad.

En el ámbito de la termodinámica, la entropía es una medida de la energía de un sistema que ya no puede ser utilizada para realizar trabajo útil. En un sistema aislado, la entropía tiende a aumentar con el tiempo, lo que refleja la irreversibilidad de los procesos naturales.

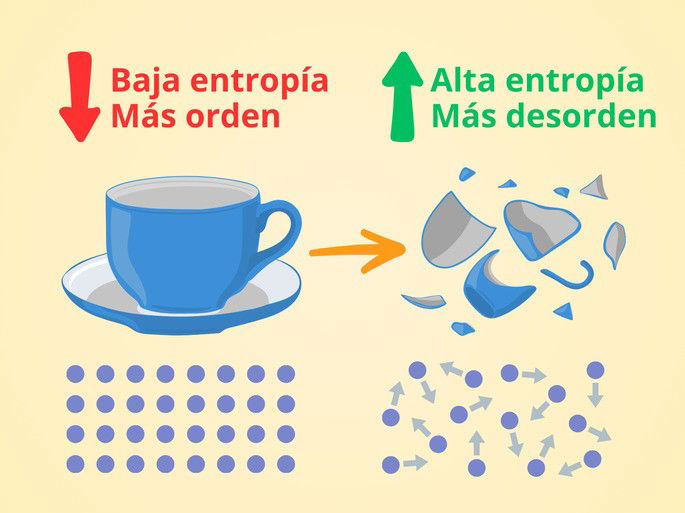

Por ejemplo, una taza contiene partículas enlazadas entre sí, formando una estructura cristalina y organizada. Debido a esto, la energía se puede transmitir fácilmente entre las partículas y aprovecharse para realizar un trabajo útil. Decimos entonces que la entropía es baja.

Ahora, si rompemos la taza en muchos trozos pequeños, las partículas estarán más separadas y desorganizadas. Por ello, la energía no se transmite de forma eficiente entre las partículas, pues la entropía es más alta. Sumado a lo anterior, estos trozos no se juntarán espontáneamente, sino que nosotros debemos realizar un trabajo sobre ellos y transmitir energía para reconstruir la taza.

El término de la entropía fue acuñado por el físico alemán Rudolf Clausius en el siglo XIX. Fue en el contexto de la segunda ley de la termodinámica, al observar que, en todo proceso irreversible, una parte de la energía se transforma en una forma no utilizable para realizar trabajo.

El concepto de entropía se ha extendido a otras disciplinas, donde funciona como una medida del grado de incertidumbre, desorden o aleatoriedad de un sistema.

Por ejemplo:

- En física, la entropía expresa la irreversibilidad de los procesos termodinámicos y la tendencia al equilibrio térmico.

- En química, está asociada a los cambios de estado y a la espontaneidad de las reacciones.

- En astrofísica, se estudia la entropía en fenómenos como la radiación cósmica o los agujeros negros.

- En teoría de la información, indica el grado de imprevisibilidad de un mensaje o conjunto de datos.

- En informática, se usa para medir la aleatoriedad necesaria en algoritmos criptográficos.

Fórmula y unidades de la entropía

La entropía se relaciona con la transferencia de calor y la temperatura con la siguiente fórmula:

Lo que nos dice esta fórmula es que la entropía de un sistema (ΔS) varía en función del calor que intercambia dicho sistema con otro (Q) a una temperatura determinada (T). Como el calor se expresa en julio, J, y la temperatura en kelvin, K, las unidades de la entropía son julios sobre kelvin, J / K.

Cabe mencionar que la fórmula solamente es una ecuación cuando se trata de un proceso reversible. Como los procesos naturales son irreversibles, la variación de entropía siempre será mayor a la razón del calor intercambiado sobre la temperatura a la que sucede el proceso.

Por ejemplo, si un sistema intercambió 500 julios de energía térmica con el entorno a una temperatura de 25 °C, que correspondería a 298,15 K, entonces:

La entropía del sistema varió, por lo menos, 1,677 J / K. Si se trata de un proceso irreversible, la entropía habrá variado más que la energía utilizada para llevar a cabo el proceso. Es decir, parte de la energía no se ha podido aprovechar para realizar un trabajo útil en el proceso. Esta es una de las claves en la segunda ley de la termodinámica.

Otra fórmula utilizada para representar la entropía, que nos lleva a otra definición, es la siguiente:

ΔS = kB lnΩ

En el que ΔS es la variación de entropía, kB es la constante de Boltzmann (equivale a 1,380 649 x 10-23 J / K), y lnΩ el logaritmo natural (ln) del número de microestados (Ω) en el sistema. Es decir, la variación de entropía aumenta proporcionalmente con el número de microestados.

Pero, ¿qué es un microestado? Esa variable indica el número de configuraciones en las que se pueden ordenar las partículas de un sistema.

Por ejemplo, un metal a temperatura ambiente tiene gran parte de sus partículas organizadas de una forma concreta. Ahora, como los átomos vibran y hay electrones que viajan, el metal puede presentar centenares o miles de microestados.

Un gas, en cambio, contiene partículas que se desplazan constantemente, chocando entre sí y cambiando de dirección. Es por eso que un gas presenta mayor variación de entropía, pues el número de microestados es considerablemente mayor.

Con razón de la tercera ley de la termodinámica, en el cero absoluto se establece la entropía como nula. El motivo es que, si consideramos que la materia forma una sustancia cristalina perfecta, en el cero absoluto las partículas ni vibran ni se mueven. Por tanto, solo presentan un microestado, y como el logaritmo natural de 1 es 0 (ln1 = 0), no hay variación de entropía.

Ver también Termodinámica y Leyes de la termodinámica.

Ejemplos de entropía

Un ejemplo cotidiano es cuando se introduce un cubo de hielo en un vaso de agua a temperatura ambiente. A medida que el hielo se derrite y el agua se enfría, el sistema alcanza un equilibrio térmico. Durante este proceso, la energía térmica se redistribuye de forma más homogénea: el sistema se vuelve más desordenado, y, por tanto, aumenta su entropía.

Otro ejemplo que alude al concepto de entropía es la eficiencia del motor de un vehículo. Idealmente, deseamos que todo el calor generado por la combustión se emplee para realizar un trabajo mecánico en forma de desplazamiento. No obstante, parte de la energía se disipa en forma de calor o se envía al tubo de escape, por lo que no toda la energía se transforma en trabajo útil.

Otro caso para ilustrar la entropía es la degradación de sustancias orgánicas. Con el tiempo, la materia orgánica muerta se degrada, deshaciéndose y esparciendo sus partículas, aumentando así su entropía. La materia orgánica siempre sigue este curso a menos que destine energía en mantenerla y desarrollarla.

En otras palabras, los seres humanos obtenemos energía para "combatir" nuestra tendencia a aumentar la entropía.

Entropía negativa

La entropía negativa, también conocida como neguentropía, describe el proceso mediante el cual un sistema abierto puede exportar entropía al entorno para mantener un nivel interno de orden.

Esta idea fue popularizada por el físico Erwin Schrödinger. Él observó que los seres vivos consumen energía del entorno (por ejemplo, a través de los alimentos o la luz solar) para conservar su organización interna y retrasar la degradación.

En este sentido, la vida misma puede entenderse como una lucha constante contra la entropía. En contraposición, un sistema aislado, que no intercambia energía ni materia con el entorno, está condenado a una aumento de entropía y desorganización progresiva.

Vea también:

Cómo citar: Rhoton, Stephen (15/08/2025). "Entropía". En: Significados.com. Disponible en: https://www.significados.com/entropia/ Consultado: